AI will not replace people, but people who use AI will replace those who don’t.

Andrew Ng

Uitgangspunt voor deze cursus is Co-intelligentie: een professional met AI-assistentie. Hierbij zijn de volgende zaken essentieel:

- als professional blijf je verantwoordelijk voor het resultaat

- als professional moet je de AI duidelijke opdrachten kunnen geven

- als professional moet de de AI-resultaten goed kunnen beoordelen

- je professionele kennis en vaardigheden blijven belangrijk

Je kunt dit vergelijken met de situatie in de luchtvaart: een piloot met een automatische (co)piloot. Ook daar is het essentieel dat de menselijke piloot zelfstandig kan vliegen, ook in lastige situaties. Piloten worden voortdurend getraind en getest om hun expertise in stand te houden en te verbeteren.

Co-intelligentie is uitgebreid beschreven door Ethan Mollick, in het gelijknamige boek.

Opdracht geven aan AI. Om een AI-assistent zinvol werk te laten doen, moet je deze duidelijke instructies geven. In het geval van AI-chatbots zoals ChatGPT heet zo’n opdracht een prompt. Een eerste stap is dat je leert om goede prompts te maken: het verschil in resultaat tussen een (te) eenvoudige prompt en een goede prompt is erg groot.

(Docenten weten dat een onduidelijke opdracht voor leerlingen grote invloed heeft op de resultaten die ze van de leerlingen terugkrijgen, op de gemiddelde kwaliteit daarvan en op de variatie in kwaliteit. Een duidelijke opdracht geeft veel betere resultaten: een betere gemiddelde kwaliteit en minder variatie in kwaliteit. Dit geldt ook voor prompts voor een AI-chatbot.)

Grillige grens van AI resultaten.

CHatGPT (en andere generatieve AI zoals Anthropic Cluade, Google Gemini of Microsoft Copilot, enz.) geeft soms een resultaat dat er heel professioneel uitziet, maar dat feitelijk onjuist is. We spreken dan over een hallucinatie. Om zo’n hallucinatie van een correct resultaat te kunnen onderscheiden, moet je de feiten kunnen controleren, en moet je soms ook de nodige professionele kennis en vaardigheden hebben.

Daarnaast kan ChatGPT ook met een overduidelijk fout antwoord komen, of soms aangeven dat deze het antwoord niet kan bepalen.

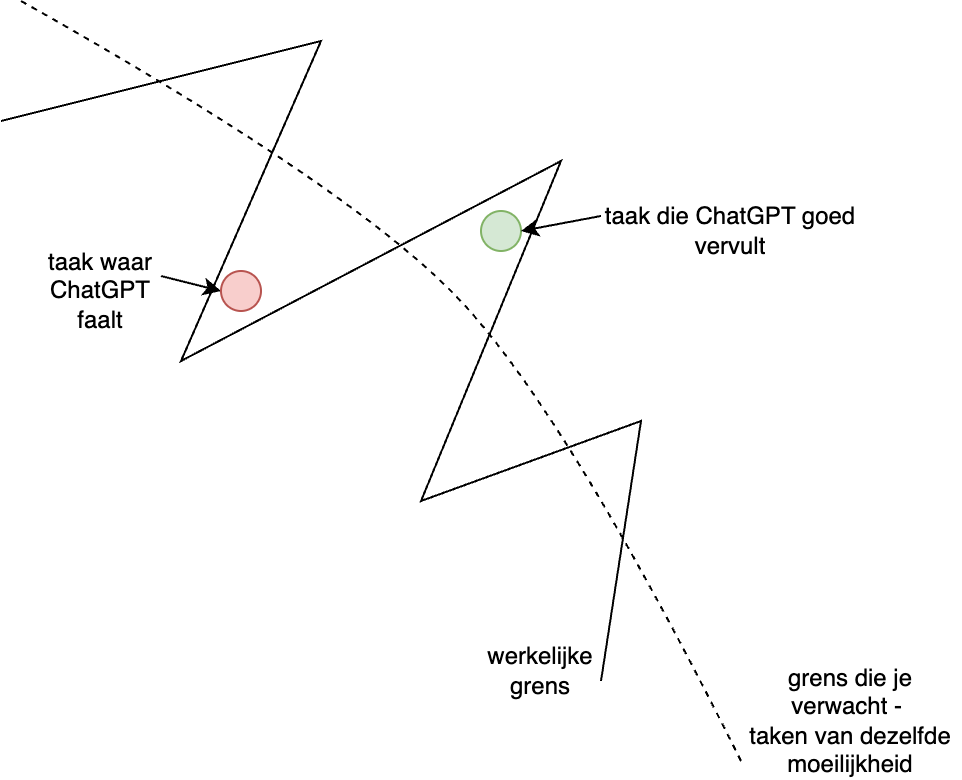

De grens tussen de gevallen waar ChatGPT faalt -al dan niet met een hallucinatie-, en waar je een goed resultaat krijgt, is erg grillig: soms word je verrast door een perfect resultaat bij een lastige vraag; en soms faalt ChatGPT bij een ogenschijnlijk eenvoudig probleem. Eén van de zaken die je moet leren in het werken met AI, is het omgaan met deze grillige grens. Alleen door het veel te gebruiken krijg je hiervoor een gevoel. Maar AI blijft zich (snel) ontwikkelen: deze grens verschuift in de loop van de tijd.

De grillige grens van AI: soms een verrassend resultaat bij een lastige vraag, soms een teleurstellend antwoord bij een simpele vraag.

Hoe ga je om met deze grillige grens? Probeer AI te gebruiken bij elke taak, in het bijzonder als die taak veel tijd kost. Gebruik een duidelijke instructie voor de AI, in de vorm van een gestructureerde prompt. Controleer altijd het resultaat: als dit goed is, of bijna goed, ben je (bijna) klaar. Eventueel pas je het resultaat aan door een vervolgvraag in de chat, of door een nieuwe verbeterde prompt in te voeren.

Als het resultaat niet goed genoeg is, kun je eventueel een andere aanpak proberen. Maar besteed er niet teveel tijd aan: profiteer eerst van het laaghangende fruit. Documenteer wat je probeerde, en wat er niet goed aan was, en laat dit voorlopig liggen. In de toekomst kun je het opnieuw proberen, als je zelf handiger geworden bent in het gebruik van AI, en als de AI beter geworden is.

Gevolgen voor het onderwijs¶

Voor leerlingen is de inhoud van het huidige onderwijs nog steeds relevant: dit legt de basis voor de kennis en vaardigheden die je later nodig hebt, in studie en beroep. Daarnaast is het belangrijk dat je AI kunt inzetten voor het eigen leren en als hulpmiddel voor bijvoorbeeld projecten. Informatievaardigheden heb je nodig om de resultaten van AI te kunnen beoordelen.

De grote uitdaging voor het onderwijs is om leerlingen te leren AI in te zetten voor hun eigen leerproces. Ook als ze AI inzetten als hulpmiddel bij een project o.i.d. kunnen ze dit gebruiken om te leren. Dit legt de basis voor een professionele houding ten opzichte van AI als assistent - en als middel om van te leren.

Voorbeeld: Boston Consultants Group¶

Zie:

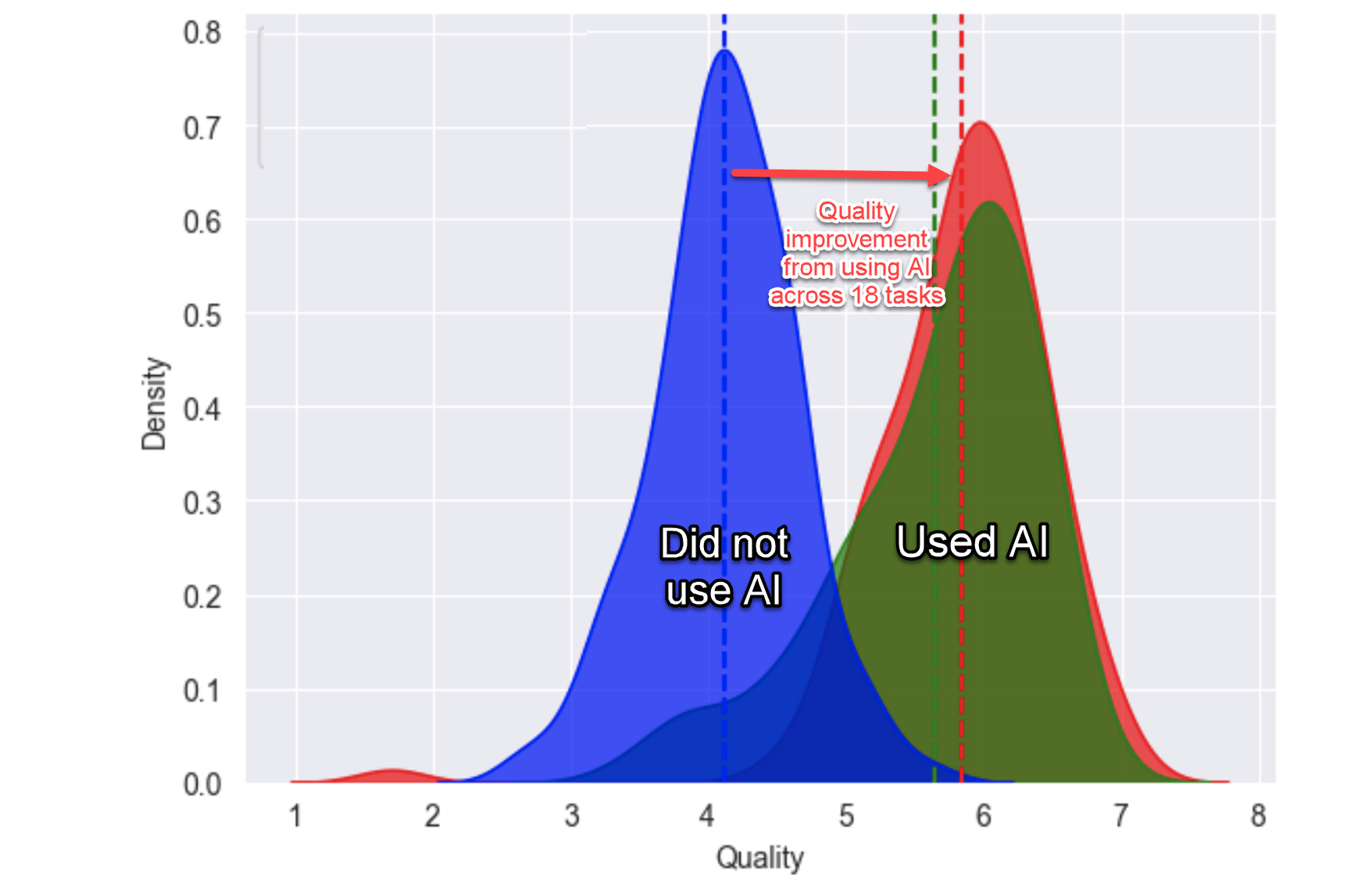

In 2023 heeft Hardvard University in samenwerking met de Boston Consultancy Group een experiment uitgevoerd onder 758 consultants. Deze moesten 18 typische consultants-taken uitvoeren, de ene groep consultants zonder AI, de andere groep met behulp van AI (ChatGPT 4). Dit experiment is beschreven in de blog-post van Ethan Mollick (Centaurs and Cyborgs on the Jagged Frontier), en in het working paper van Harvard Business School (Dell’ Acqua, 2023).

De onderstaande grafieken geven enkele van de belangrijkste resultaten van dit onderzoek weer.

Resultaten van consultants met (groen en rood) of zonder (blauw) gebruik van AI (ChatGPT-4). De rode groep kreeg extra hulp voor het schrijven van goede prompts.

De consultants die AI gebruikten:

- waren veel minder tijd nodig (75%) voor de taken, en

- behaalden veel betere resultaten (40% beter, gemiddeld).

In het bijzonder behaalden “middelmatige” consultants “zeer goede” resultaten. Iedereen die AI gebruikte kreeg betere resultaten, maar de verbetering was kleiner voor de zeer goede consultants.

Deze resultaten golden alleen voor de taken die binnen de “grillige grens” vallen; voor taken die daarbuiten vallen, werkt het gebruik van AI soms averechts: sommige consultants vertrouwden teveel op AI, en gebruikten te weinig hun professionele kennis en vaardigheden.

Voorbeeld: Medische diagnostiek¶

Voorbeeld: Rechtenstudenten¶

Voorbeeld: Programmeren en Software Engineering¶

Als Software engineer kun je op twee manieren omgaan met AI:

- (A) je kunt vrijwel al je werk uitbesteden aan AI, en er verder nauwelijks naar omkijken; of

- (B) je kunt werk uitbesteden aan AI, waarbij je voortdurend een vinger aan de pols houdt, en de AI bevraagt naar de keuzes die deze maakt, naar alternatieven, en waarbij je alleen uitwerkingen accepteert die je zelf begrijpt en goedkeurt.

Voorbeeld: AI als teamlid¶

Ethan Mollick: The Cybernetic Teammate

- Dell’Acqua, F., McFowland, E., Mollick, E. R., Lifshitz-Assaf, H., Kellogg, K., Rajendran, S., Krayer, L., Candelon, F., & Lakhani, K. R. (2023). Navigating the Jagged Technological Frontier: Field Experimental Evidence of the Effects of AI on Knowledge Worker Productivity and Quality. SSRN Electronic Journal. 10.2139/ssrn.4573321